Uno de los más apasionantes desafíos de la ciencia contemporánea es la consciencia. No sabemos exactamente qué es (a pesar de tenerla tan cerca), pero múltiples investigadores de diversos campos (informáticos, neurólogos, psicólogos, filósofos, etc ) se están aventurando en la sugerente tarea de comprenderla y replicarla. Desde sus comienzos, allá por mitad del siglo XX, la inteligencia artificial ha pretendido emular a los dioses y crear seres a su imagen y semejanza. En algunos campos lo ha conseguido. Tenemos máquinas que hacen cálculos, razonan y memorizan mucho mejor que nosotros. Sin embargo, hay un lugar misterioso que se resiste a la ciencia: la consciencia. Mientras que para nosotros es de lo más habitual sentir que nos duele una muela, algo así es un profundo enigma para nuestros ingenieros. ¿Cómo construir un robot que pueda sentir? Y es más: ¿cómo hacer un robot que tenga consciencia de sí mismo, que sepa que existe, que tiene una biografía y un yo separado del mundo exterior? Hasta hace poco, sólo escritores de ciencia-ficción como Isaac Asimov se atrevían a reflexionar sobre algo así, pero en la actualidad parece que ya tenemos algunas pistas.

Concretamente en España tenemos la suerte de tener a uno de los mayores expertos del mundo en consciencia artificial. Raúl Arrabales es Doctor en Inteligencia Artificial y director del área de ingeniería en el Centro Universitario U-Tad. Arrabales es diseñador de la arquitectura cognitiva CERA (Conscious and Emotional Reasoning Architecture) y de ConsScale, una herramienta para medir la consciencia. Ganó el premio 2K Botprize junto con Jorge Muñoz en 2010, aplicando inteligencia artificial a videojuegos. Ha publicado más de cuarenta artículos en revistas especializadas y ha dado múltiples conferencias internacionales. También es experto en gestión de empresas de desarrollo tecnológico, siendo el co-fundador de Comaware, una empresa de software de consciencia artificial que ganó el premio Emprendedor Universitario en el año 2011. Hoy tenemos la enorme suerte de poder entrevistarlo en exclusiva para Hypérbole.

Una de sus aportaciones más famosas es la escala ConsScale: una herramienta capaz de medir el grado de consciencia de un determinado organismo, ya sea biológico o artificial. Sin embargo, parece que la consciencia puede no ser una cuestión de grado. Parece que o soy consciente de algo o no lo soy en absoluto. Yo siento el dolor de muelas o no lo siento, no existiendo un “ser parcialmente consciente del dolor”. En este sentido, ConsScale sólo hablaría de consciencia plena a partir del nivel 6 (consciencia emocional), siendo todos los niveles anteriores totalmente inconscientes. ¿Cómo responde a esta objeción?

La escala ConsScale pretende medir el desarrollo cognitivo que presenta un sujeto y se basa en la hipótesis de que la conciencia humana aparece gracias a la interacción y composición sucesiva de diversas capacidades cognitivas. Estas habilidades, desde las más básicas, como el aprendizaje de respuestas reactivas estímulo-respuesta (condicionamiento clásico), hasta las capacidades cognitivas superiores, como la capacidad de ponerse en el lugar del otro (empatía), son necesarias para experimentar todo el rango de contenidos conscientes que aparecen en los humanos.

ConsScale por lo tanto se asienta en la hipótesis de que la conciencia que experimentamos los humanos se desarrolla de forma gradual, tanto a nivel ontogénico (del desarrollo del individuo hasta hacerse adulto) como a nivel filogenético (a través de la evolución de las especies).

Para responder a la objeción que se plantea, en la que se identifica la conciencia como un proceso binario (que está totalmente presente o no lo está en absoluto) es necesario diferenciar entre conciencia transitiva y conciencia intransitiva.

La conciencia intransitiva se refiere simplemente a la sensación de presencia, sentir el aquí y el ahora, pero sin hacer referencia a ningún objeto. Esta dimensión de la conciencia sí que podría considerarse más fácilmente como una propiedad que se “enciende” y se “apaga” y sería una base para la existencia de la conciencia transitiva.

La conciencia transitiva se refiere a la dimensión de los contenidos de la conciencia, es decir, hay un objeto del que se es consciente. La conciencia transitiva implica ser consciente de algo, por ejemplo ser consciente de un dolor de muelas. Lo interesante aquí es que se requiere una gran capacidad cognitiva para ser consciente como lo es un humano de un dolor de muelas. Por citar un solo aspecto, un adulto con dolor de muelas no es sólo consciente del dolor en sí mismo, sino que además es consciente de que le duele a él (porque tiene una habilidad cognitiva para representar su propio yo en su mente).

Desde el punto de vista de ConsScale existe una diferencia cognitiva entre la experiencia del dolor de muelas de un perro y la experiencia de dolor de muelas de un humano adulto. Mientras que el perro se encuentra en el nivel 4 de la escala y por lo tanto no es consciente de sí mismo, es decir, no tiene un yo que sea el objeto de su conciencia transitiva, el humano, que está en el nivel 10, tiene una experiencia mucho más rica en contenidos conscientes. De hecho, lo normal es que el humano tenga pensamientos relacionados con el dolor de los que también sea consciente y modulen en gran medida la sensación experimentada. Por ejemplo, el dolor puede evocar otras sensaciones relacionadas con el miedo al dentista o a perder la muela. En el caso del perro es mucho más difícil saber cuál es su experiencia subjetiva, pero seguramente no involucre pensamientos relacionados con un yo ni tan complejos como los de un humano.

Filósofos muy reputados llevan dando, desde prácticamente los orígenes de la Inteligencia Artificial, la voz de alarma sobre las limitaciones de las computadoras a la hora de realizar tareas propiamente humanas. Así tenemos a Herbert Dreyfus y sus durísimas críticas a la IA en su famoso What computers can´t do. En una línea similar, aunque menos agresiva, tenemos a John Searle y su argumento de la caja china o del gimnasio chino (aplicado al programa conexionista). Parece complicado que las computadoras puedan desear, sentir o tener simples estados mentales similares a los nuestros. ¿Qué camino hay emprendido en esta línea? ¿Tenemos alguna pista de por dónde podrían ir los tiros?

Mi punto de vista es que las técnicas ya clásicas de Inteligencia Artificial, las que se sigue enseñando en mayor medida en la universidad (redes de neuronas, algoritmos genéticos, árboles de decisión, lógica borrosa, motores de inferencia, etc.) tienen una limitación clara tal y como apuntan estos autores, aunque sean de gran utilidad en determinados dominios de aplicación.

Hoy en día la investigación en sistemas cognitivos, tanto naturales como artificiales, creo que nos ha dado una pista muy valiosa sobre el camino más prometedor que podríamos seguir. Los investigadores que intentamos construir robots con comportamientos tan complejos como los típicamente humanos nos hemos dado cuenta de que es inútil tratar de preprogramarlo todo. El mundo real es demasiado complejo como para tenerlo todo previsto de antemano. De hecho los humanos, pese a nuestra dotación genética, necesitamos un largo periodo para aprender tareas como caminar o hablar. Por lo tanto, parece que la clave está en el desarrollo y en la interacción con el medio. Creo que actualmente las líneas de investigación más prometedoras son las que se centran en construir máquinas con la capacidad de interactuar con su entorno y desarrollarse cognitivamente en base a esa interacción.

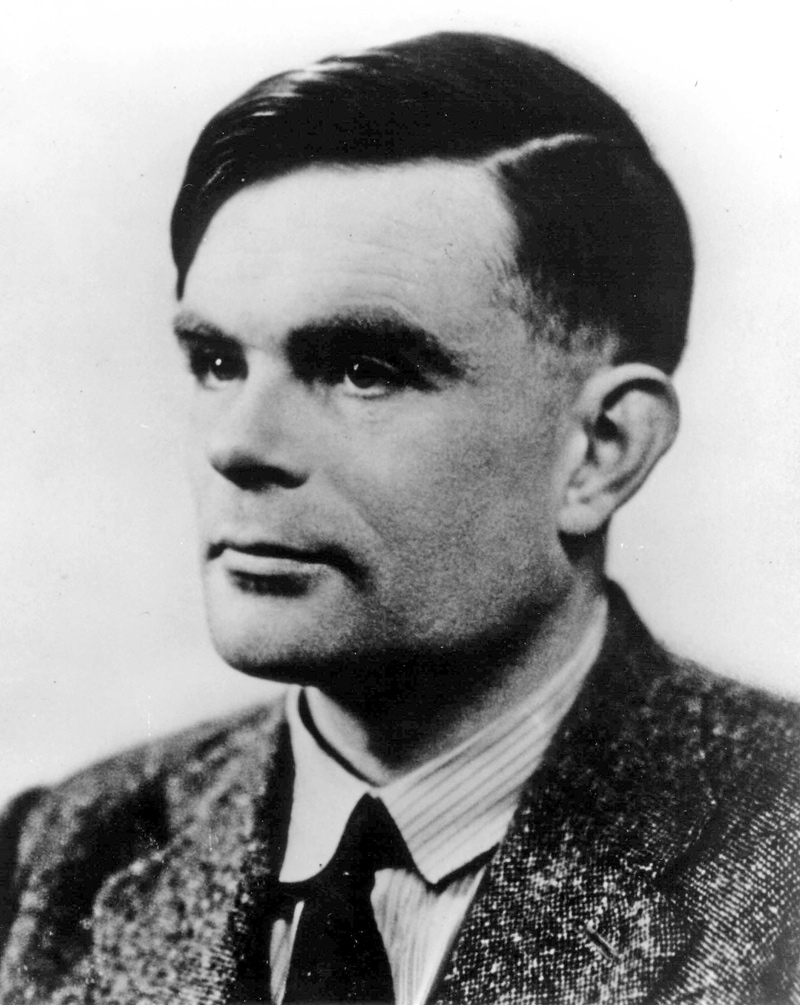

Ya que estamos celebrando el centenario de nacimiento de Alan Turing, en esta entrevista no podría faltar hablar de él. Una de las ideas más controvertidas de su celebérrimo test es la de copia o simulación. Parece que podríamos diseñar una máquina que superara el test, simplemente, aparentando ser un humano pero no siéndolo. La máquina no tendría por qué comprender el lenguaje que usa, simplemente, debería usarlo de modo que nos engañara al hacerlo. Pero parece patente que eso no es pensar en un sentido clásico. Tendríamos una máquina que hace cómo que piensa, pero que no piensa. Searle lo dice con mucha claridad: por mucho que la copia se asemeje muchísimo a lo que pretendemos copiar, una perfecta copia en un computador de lo que es la leche no se puede beber. Usted y todos los investigadores en consciencia artificial hablan de arquitecturas, de sistemas ordenados que puedan emular lo que hace un ser humano, pero, una arquitectura no será más que una copia de un proceso real y no ese proceso real. ¿Podrán esas arquitecturas “beberse”? ¿Qué opina usted del test o de las ideas de Turing y de las críticas recibidas?

A este respecto yo soy mucho más pragmático: como se suele decir, si tiene cuerpo de pato, anda como un pato y hace cua como un pato, pues será que es un pato. Aquí, para contestar totalmente a la pregunta sobre si podría “beberse” (o “comerse” en este caso), añadiría también que se puede cocinar y comer igual que un pato. En definitiva, si un robot pasa el test de Turing y logra “engañar” a cualquier humano que lo ponga a prueba no tiene sentido preguntarse si este robot por dentro tiene o no las mismas sensaciones que yo. O mejor dicho, no tiene más sentido que preguntárselo acerca de cualquier otro humano.

Dicho lo anterior, ciertamente el test de Turing original tiene limitaciones, pero podríamos adoptar variaciones más exigentes que se han propuesto posteriormente, como el T3 (Total Turing Test), en el que para superarlo un robot tendría que pasar inadvertido como si fuera un humano cualquiera, igualmente integrado en la sociedad en la que vive. Si el proceso que realiza ese robot para pasar inadvertido es real o no para mí tiene una respuesta clara: es tan real como que le permite al robot comportarse efectivamente de la misma forma que lo hace un humano.

Otros pensadores critican la IA en el sentido de que, realmente, la base científica que tenemos para sustentar la posibilidad de consciencia artificial es muy bajo. A pesar de que poseemos instrumentos de observación neuronal cada vez más sofisticados y precisos, sólo tenemos una correlación entre estados mentales y estados neuronales. Cuando yo siento que me pica la nariz, una parte de mi cerebro se enciende, pero nada más. Sabemos que la intensidad eléctrica, ciertas ondas o el riego sanguíneo se amplían en ciertas zonas cuando pensamos o sentimos, pero parece que no hay ninguna conexión más que podamos establecer. Y es que, ¿no parece un poco apresurado afirmar que un conjunto de impulsos eléctricos entre neuronas causen la consciencia? ¿Qué tendrá que ver la electricidad o el mero flujo de información con que yo sienta que me pica la nariz?

Cierto es que aún no existe un consenso en la comunidad científica acerca de cuál es el proceso exacto que produce la conciencia. Hoy en día existen diversas teorías que tratan de explicar la conciencia desde diferentes niveles de descripción. A nivel físico uno puede fijarse en los impulsos eléctricos en el sistema nervioso, pero ese mismo proceso se puede ver también desde el punto de vista de la información. Por ejemplo, hay científicos, como Giulio Tononi y sus colegas, que afirman que la conciencia tiene su origen en los procesos de integración de la información. Asimismo, el sistema nervioso también puede analizarse desde el punto de vista funcional y estructural o, incluso, se puede estudiar un organismo a nivel cognitivo viendo cómo se relaciona con el medio. Es más, como he comentado antes, también es interesante estudiar un organismo desde el punto de vista epigenético y del desarrollo.

Quizás lo que necesita la comunidad científica es reconciliar todos estos enfoques que se realizan a diferentes niveles para llegar a una descripción del fenómeno de la conciencia que la explique en su conjunto. No creo que centrarse exclusivamente en la electricidad o en la información nos dé la solución. En este sentido, veo que la investigación en conciencia artificial es de gran importancia porque puede ayudar a resolver algunas de las hipótesis que se plantean acerca de los organismos biológicos.

El famoso filósofo David Chalmers pone la objeción en su famosa metáfora de los zombis. No hay impedimento lógico en pensar que podríamos diseñar un zombi, un ser humano ya sea mecánico o biológico, que podría hacer lo mismo que nosotros pero sin tener consciencia alguna. Es lo que hacen, por ejemplo, los programas que juegan al ajedrez. Lo hacen mucho mejor que nosotros pero no tienen consciencia. Aceptando la premisa, la consciencia parece ser algo inútil funcionalmente hablando, un extraño añadido que no aportaría nada a nuestros actos cotidianos en términos físicos. Además, esta postura podría volver a llevarnos a planteamientos dualistas que dejarían el camino abierto a pensar en “espíritus” o “almas”. ¿Qué piensa usted al respecto? ¿Se alinearía dentro del funcionalismo, del fisicalismo o de alguna forma de materialismo?

Yo no creo que la conciencia sea un epifenómeno (un efecto lateral que no aporta funcionalidad alguna). Más bien, opino todo lo contrario, es precisamente la capacidad de tener una experiencia subjetiva lo que dirige nuestros comportamientos más complejos.

Desde mi punto de vista, parece que la evolución no ha tenido más remedio que usar la conciencia como medio para diseñar máquinas capaces de comportamientos adaptativos en medios complejos y dinámicos. Además, también veo claro que la conciencia, pese a no ser física, tiene un origen causal en un organismo material (de igual forma que un proceso software ejecutándose en un ordenador no es físico, pero se produce gracias a la acción de mecanismos físicos).

Para mí el alma o el espíritu de un ser reside en su capacidad de experimentar un mundo interior. Además, esa experiencia subjetiva y privada tiene una función muy importante: guiar el comportamiento, la toma de decisiones. Esto nos lleva a la cuestión del libre albedrío, otro aspecto que genera gran controversia.

Aunque se pudiera considerar que el libre albedrío y la conciencia en sí no son más que ilusiones o alucinaciones lo cierto es que estas alucinaciones guían parte de nuestro comportamiento y a efectos prácticos, desde un punto de vista subjetivo, eso implica que tenemos libertad en la toma de decisiones (para mí es irrelevante si a esa sensación de libertad se le pone el adjetivo “ilusoria”).

¿Qué opinión le merece la teoría de los microtúbulos de Roger Penrose? ¿Tiene algún sentido hablar de física cuántica al referirnos a la consciencia?

Hameroff y Penrose tratan de dar una explicación a la conciencia intransitiva o de estado. Para ellos tiene todo el sentido hablar de física cuántica porque su hipótesis es que la conciencia se produce gracias a mecanismos de coherencia cuántica. Mi opinión en general es que la conciencia es más dependiente del proceso que del sustrato. Es decir, que es más importante entender cuáles son los procesos específicos que producen este fenómeno. Hameroff y Penrose estudian el sistema nervioso desde el punto de vista de los procesos cuánticos que supuestamente se producen en los microtúbulos o en los canales iónicos de las redes dendríticas (gap junctions), pero para mí lo realmente importante es descubrir qué papel podrían tener estos procesos de coherencia o sincronización a nivel de procesamiento de la información.

¿Somos información simbólica? ¿Es adecuado el modelo computacional de la mente para describir lo qué es realmente la mente o aún nos falta algo?

Yo veo la conciencia como el nexo de integración entre la información simbólica y subsimbólica. De hecho, podría describirse la conciencia como el mecanismo que permite generar información simbólica con un significado a partir de información subsimbólica. Obviamente la mente no funciona como un ordenador convencional, con lo que no me parece adecuado describir la mente como una máquina de Von Neumann.

El gurú de la robótica Raymond Kurzweil habla con total tranquilidad de lo que se ha entendido como singularidad tecnológica: un momento en el tiempo en el que las máquinas estén tan desarrolladas que hagan descubrimientos inimaginables para nuestras débiles inteligencias de carne y hueso, por lo que realizar cualquier pronóstico histórico desde ese momento está por encima de nuestras posibilidades. ¿Cree usted que llegará ese momento? ¿Nos sustituirán las máquinas en el quehacer científico y en Dios sabe qué otras facetas?

Yo no lo veo como un punto de inflexión tan radical, sino como un cambio progresivo que implicará una co-evolución de humanos y máquinas. Aunque estoy de acuerdo en que es muy difícil predecir cómo será esta evolución, tan difícil como prever el devenir de la economía de un país.

¿Nos dominarán las máquinas tal y como se ha fabulado tanto en películas de ciencia-ficción como Terminator o Matrix?

Para mí el escenario más plausible no es el de sustitución o conquista, sino el de mezcla e integración: la aparición progresiva de una raza nueva, el post-humano, mezcla de humano y máquina.

Otro concepto que suele usarse con mucha normalidad es el de Mind Uploading: poder cargar nuestra mente en un computador. Las consecuencias de algo así serían fascinantes: nos haríamos potencialmente inmortales al abandonar nuestros frágiles cuerpos. ¿Opina usted que algo así será posible?

En la línea de mi comentario anterior, veo más posible el concepto de mente extendida. Más que descargar mi mente a un ordenador, lo que podré hacer es distribuir mi mente en diferentes dispositivos integrados en mi cuerpo o externos, pero conectados. Más que en la inmortalidad, creo en la “mortalidad constante”, teniendo en cuenta que la mente es un proceso constante de recreación del yo. Cada día que pasa un yo deja de existir para dar paso a uno nuevo un poco diferente del anterior, si podemos mantener este proceso de cambio constante utilizando diferentes sustratos, la ilusión del yo podría mantenerse indefinidamente.

También se habla mucho de la emergencia de una conciencia global. Se habla de que Internet podría llegar a independizarse de algún modo de sus operadores humanos para ser un organismo autónomo. ¿Tiene esta idea alguna base real o es una mera idea ingeniosa de autores de ciencia-ficción?

Desde luego, la autonomía tiene relación con la conciencia, en el sentido de que un organismo que toma sus propias decisiones para adaptarse al medio parece ser uno de los motivos por los cuales aparece la conciencia en la naturaleza. Sin embargo, tal y como es en la actualidad, yo veo Internet como una herramienta que usamos los humanos: no es la red la que toma decisiones para adaptarse al medio y hacerse autónoma, somos los ingenieros los que tomamos decisiones de diseño sobre la red y la adaptamos a nuestras necesidades. En todo caso, Internet podría ser una parte más de sustrato capaz de mantener una mente extendida.

Las promesas de la IA parecen todavía muy lejanas aunque usted afirma que quizá no están tan lejos como todo el mundo piensa. ¿A qué se debe este optimismo? ¿Se atrevería a hablar de fechas?

Las promesas originales de la IA puede que estén todavía muy lejos, pero se puede ser razonablemente optimista acerca de nuevas promesas renovadas. Por ejemplo, es patente que aún no somos capaces de construir un robot humanoide como los de las películas de ciencia ficción, pero sí se está alcanzando el objetivo mucho más modesto de imitar el comportamiento humano en un entorno mucho más limitado como es el de un avatar de videojuego. No sabría dar fechas concretas, pero me parece probable que en los próximos 5 ó 10 años nos acostumbremos a interactuar con personajes virtuales que cada vez nos parezcan más realistas y humanos, hasta que llegue un momento en que no seamos capaces de distinguir si el avatar de servicio al cliente de una página web está controlado por un humano o por un programa software.

Sus investigaciones podrían chocar con las creencias religiosas de muchísimas personas. La mayor parte de la humanidad cree en la posibilidad de otra vida, cree que posee un alma que vivirá tras la muerte. Si usted diseñara un robot consciente y demostrará que no hace falta un Dios para dotarnos de subjetividad, al igual que Galileo o Darwin, se enfrentaría de lleno con las principales religiones. ¿Es usted creyente? ¿Cree que podría existir vida después de la muerte? ¿Podrían sus máquinas tener algún tipo de experiencia religiosa?

Creo que el ejercicio de la ciencia no está reñido con la fe. De hecho, pienso que los científicos somos creyentes en el método científico. Lo que hace particularmente complicado el estudio de la conciencia es precisamente que no es fácil aplicar el método científico. Es como si el fenómeno de la conciencia se hallara entre dos mundos: el de la fe y el de la ciencia. De todas formas, como ingeniero que trata de dar soluciones en un campo multidisciplinar, ver estos dos mundos como opuestos o enfrentados no tiene sentido para mí. Es una decisión personal de cada uno decidir qué camino tomar para la búsqueda de un sentido trascendental de la vida. En cuanto a la vida y la muerte, ambos estados me parecen subjetivos, de nuevo cada persona es libre de decidir qué significa para uno mismo trascender a la muerte física del cuerpo. Por ejemplo, cuando uno está inconsciente o en un estado alterado de la consciencia, ¿está vivo? ¿Está “en pausa”? Al despertar o al recuperar el estado normal de la conciencia ¿Es uno la misma persona que era antes?

Una máquina con el suficiente desarrollo cognitivo (a partir del nivel 9 ConsScale) podría tener creencias relacionadas con la religión, no veo razón alguna por la que esto no pudiera suceder.

¿En qué está usted trabajando ahora? ¿Se está usted ya haciendo rico con Comaware?

Los objetivos originales de Comaware eran demasiado ambiciosos y quizás poco realistas para el entorno actual, aunque nuestra motivación nunca fue puramente económica. Ahora seguimos teniendo objetivos igualmente ambiciosos, pero con una planificación a más largo plazo que no requiera grandes inversiones de alto riesgo técnico y financiero. Tanto mi socio Jorge Muñoz como yo estamos desarrollando nuestras carreras profesionales en el ámbito de la tecnología y los contenidos digitales, donde esperamos encontrar nuevos socios, alianzas y aplicaciones prácticas a medio plazo.

Ahora me interesa particularmente la aplicación de los sistemas cognitivos artificiales en los videojuegos, redes sociales, juegos serios y simuladores. Creo que el sector de los contenidos digitales ya está experimentando un gran crecimiento y esto no ha hecho más que empezar. Creo que el desarrollo de este tipo de tecnología es una de las áreas en las que España puede competir al más alto nivel y convertirse en referencia mundial.