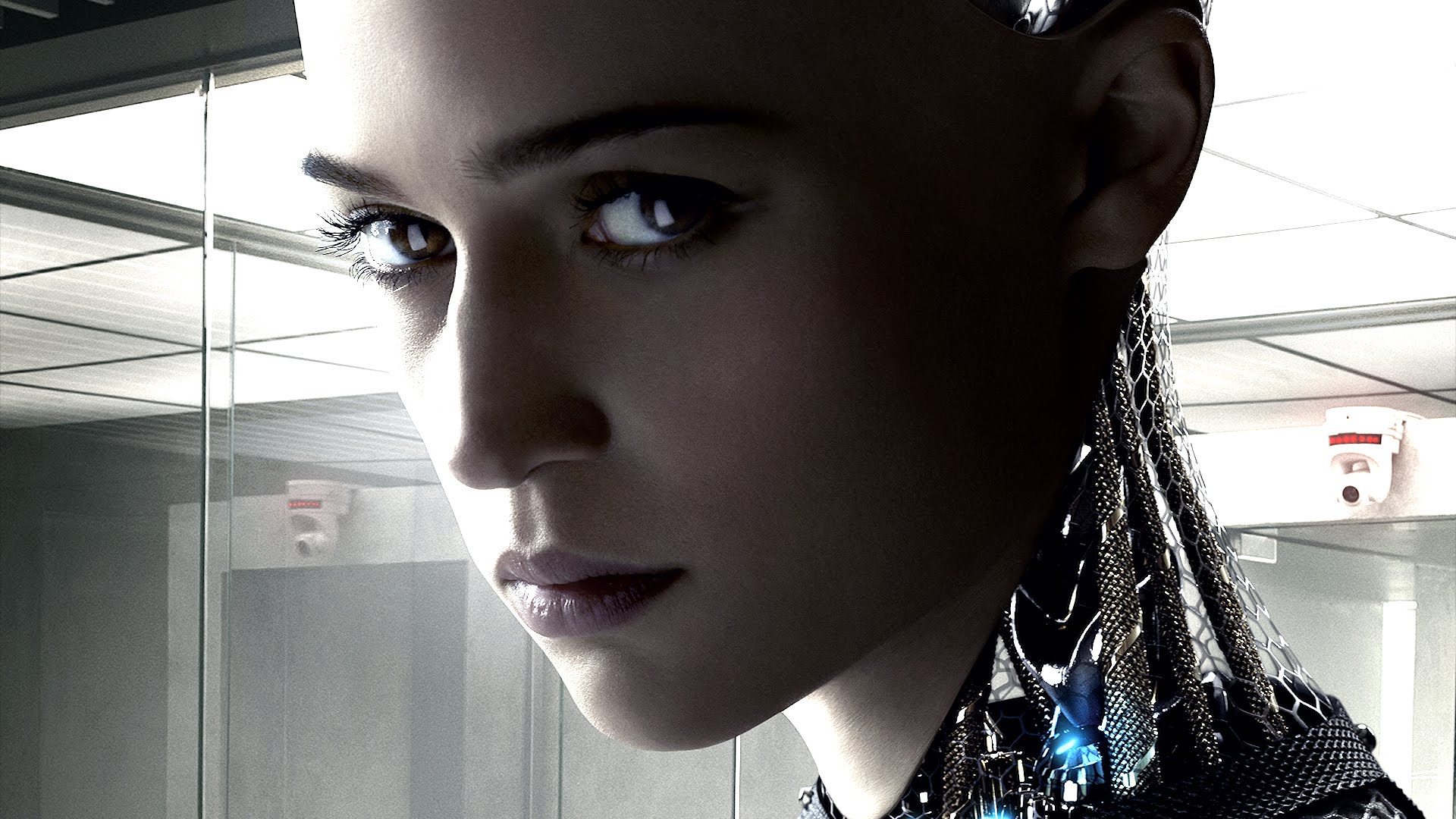

Llevo unos días un tanto consternado porque, a pesar de que estoy completamente seguro que mis artículos son leídos fervientemente en Silicon Valley, ahora se están duplicando los trabajos y publicaciones que hablan de consciencia en grandes modelos de lenguaje con desenfadada frescura y sin demasiado pudor. No obstante, también me da cierta alegría que el campo de la machine consciousness, que lleva décadas estancado (si es que alguna vez llegó a arrancar), parezca acaparar cierto interés por parte de nuevos investigadores.

El otro día discutí brevemente en X con el prestigioso informático teórico alemán Joscha Bach, uno de los defensores de que la consciencia es un proceso plenamente implementable en una computadora, un proceso de alto nivel mediante el que se experimenta la realidad como una simulación funcional, que el organismo utiliza para orientarse en el mundo (idea muy similar a la ATTENTION SCHEMA THEORY de Michael Graziano o a la postura de Karl Friston). Lo interesante es que a la conversación se unieron otros interlocutores que, en línea con Bach, me presentaron objeciones. El debate estuvo comedido y fluyó bien. A veces, X no es el pozo de basura que suele ser, sino que se puede conocer gente interesante, se puede dialogar de forma educada y compartir buena información. Es la red en la que estoy más activo (si os apetece soy @vnmachine).

Voy a ofrecer aquí un pequeño diálogo inspirado en esas conversaciones. En negrita las preguntas de mis interlocutores:

1. Si no sabemos lo que es la consciencia, ¿cómo se puede asegurar categóricamente que la IA no es consciente?

a) En ciencia (y en filosofía) no se puede afirmar nada categóricamente (Eso solo puede hacerse en demostraciones lógicas). Además, acusar a tu interlocutor de parecer mostrar demasiada certeza solo por afirmar o negar algo, es una técnica retórica fea que puede usarse con cualquier afirmación y que intenta, de forma mezquina, señalar al afirmante como dogmático. Si yo digo que Beijín es la capital de China, se me puede acusar de lo mismo. Verdaderamente no estoy 100% seguro. No he estado allí, no he hablado con las autoridades chinas para que me informen con claridad de la ubicación de su capital. Es más, incluso si hubiese hecho eso podíamos seguir manteniendo la duda, apelando a que podríamos estar en Matrix, en el Show de Truman o soñando.

b) No sé con absoluta certeza si los LLMs son conscientes, solo digo que hay tantas razones para sostenerlo que las que hay para decirlo de mi smartphone. Quizá mi smartphone sea consciente como afirma el panpsiquismo, pero si no aceptamos el panpsiquismo (y no lo aceptamos), difícilmente creeremos que tanto mi smartphone como ChatGPT son conscientes.

c) En ciencia (y en filosofía), la carga de la prueba es de quien afirma, no de quién niega. Si un ingeniero me dice que los LLMs son conscientes, es ese mismo ingeniero el que tiene que aportarme evidencias a favor de su tesis. Desde mi punto de vista (y tengo razón, jaja), no hay evidencias suficientes (ni de lejos), para justificar que los LLMs son conscientes. Que dispongamos de unos motores de inferencia estadística que han mostrado una excelente solvencia en el manejo del lenguaje o, incluso si se quiere, que han mostrado una fuerte inteligencia, no dice nada acerca de su consciencia. Hay una clara confusión entre las habilidades cognitivas superiores y la consciencia, cuando, verdaderamente, no tienen porqué tener nada que ver. Hay un acuerdo, más o menos explícito, entre los investigadores que se dedican a la consciencia, en hablar de consciencia en organismos vivos con una inteligencia muy limitada. Si aceptamos que un pez puede ser consciente y aceptamos también que un pez no es un animal muy inteligente, parece que no hacen falta unas altas habilidades cognitivas para la consciencia.

d) Sí que sabemos cosas de la consciencia, y cada vez más. Hace unas décadas dedicarte a investigar la consciencia era poco menos que un suicidio académico, pero en el presente ha renacido con mucha fuerza el estudio sobre la consciencia. Y, para sorpresa de nadie, lo que sabemos de la consciencia, no encaja para nada en el funcionamiento de los LLMs. Desarrollamos esto en la respuesta b de la pregunta 4.

2. Verdaderamente, solo tienes certeza de que tú eres consciente. Cuando otorgamos consciencia a nuestros congéneres o a otros seres vivos lo hacemos solo a través de la observación de la conducta. Si vemos que las máquinas se comportan igual que nosotros, ¿no estaríamos exigiéndoles algo que no exigimos a los demás para otorgarles consciencia?

De nuevo volvemos al problema de la innecesaria certeza. Yo solo estoy seguro de que yo soy consciente (Y ni eso: véase la crítica de Hume a Descartes), pero parece muy, pero que muy, razonable, pensar que organismos que se comportan como yo son conscientes. Así, parece de sentido común decir que mi padre, mi madre, mis hermanos, mis vecinos, etc. son conscientes. Y por si alguien no le parece suficiente podemos recurrir al argumento de la mejor teoría, que viene a decir que es razonable escoger una tesis, a pesar de que se alberguen dudas sobre ella, sencillamente porque la opuesta es muy mala. En este caso prefiero creer en que los demás seres humanos y parte del mundo animal son conscientes, a creer lo contrario, a saber, que los demás humanos que conozco son una especie de robots desalmados que se hacen pasar por seres conscientes para ignoro qué maquiavélico plan.

Pero entonces, si las máquinas se comportan como los seres conscientes ¿esto no basta? No, y me explico. No solo creemos que los demás humanos tienen consciencia porque se comporten como si la tuviesen, sino porque, interiormente, disponen de un sistema nervioso igual que el nuestro. Pensemos qué diríamos si vemos a un hombre comportándose igual que un humano consciente, pero luego descubrimos que carece absolutamente de cerebro y de todo sistema nervioso… ¿No pensaríamos entonces que su consciencia ha sido impostada de alguna extraña forma? Imaginad la macabra visión: ¡una marioneta vacía comportándose como una persona! ¿Por qué nos sentiríamos horrorizados? Porque para otorgar consciencia la conducta es insuficiente, hace falta «abrir el capó» y ver la máquina por dentro. Y aquí es donde las semejanzas se derrumban: los LLMs no tienen semejanza alguna con el tejido nervioso de los seres vivos. Si queréis echad un vistazo al artículo de Pham, Matsui y Chikazoe (2023), o al de Katyal, Parent y Alicea (2021), si bien es algo que parece bastante obvio ya a bote pronto: las redes neuronales artificiales son una casi infantil simplificación de la insondable riqueza del tejido nervioso del cerebro humano.

3. Eres un chauvinista del carbono. Nada nos dice que la consciencia solo pueda darse en sistemas nerviosos ¿Qué tiene de especial el carbono que no tenga el silicio?

De nuevo, moviendo la carga de la prueba al que niega. No estoy diciendo que la consciencia solo pueda darse en seres biológicos, solo estoy diciendo que, de momento, solo la conocemos en seres biológicos. Entonces, a falta de saber más, parece una buena hoja de ruta, primero investigar para conocer mejor, y luego intentar emular, lo que sea que ocurra en los sistemas biológicos que genere consciencia. Lo que me parece no solo muy prematuro, sino incluso rozando lo intelectualmente deshonesto, es, dado el estado de la cuestión, sostener que sí, que ya tenemos consciencia en silicio.

4. Vale, pero para que algo cumpla la misma función no tiene por qué darse en el mismo substrato. La música, por ejemplo. Una sinfonía de Mozart puede ejecutarse desde una cinta de radiocassette, desde los surcos de un vinilo, desde los voltajes de un circuito o desde las cuerdas de un violín, y no tenemos ningún problema en decir que es la misma música. Si conductual o funcionalmente, replicamos la consciencia en máquinas (lo que se llama en filosofía de la mente consciencia funcional o de acceso), ¿qué más da el sustrato? Por tanto, si los LLMs se comportan funcionalmente como seres conscientes ¿por qué no les atribuimos consciencia?

Una argumentación más interesante. En mi blog ya he hablado varias veces sobre los problemas de la tesis de la independencia de substrato o realizabilidad múltiple, pero vamos aceptarlo por mor de la argumentación. Aceptamos que si conseguimos replicar funcionalmente la consciencia en una máquina esa máquina es consciente. Sin embargo, dos objeciones serias:

a) No conocemos bien la función de la consciencia. Todo parece indicar que algo tan aparentemente sofisticado no es un epifenómeno, sino que tiene que ser una adaptación biológica, tiene que tener alguna función biológica. El problema está en que si tú puedes construir una máquina que hace todo lo que hace un ser consciente, pero sin consciencia, ¿para qué entonces la consciencia? Por ejemplo, si una máquina lee la longitud de onda de la luz que llega a su sensor y determina que su objeto es «rojo» sin sentir en ningún momento el qualia «rojo», ¿para qué vale el qualia rojo? Algunos, como mi querido Dan Dennett o Patricia Churchland, optaron por quitar de en medio los qualia designándolos como un concepto obsoleto tal como lo es el flogisto, el éter o el calórico, a la vez que hacen malabares para no prescindir de algo tan real y obvio para todo ser humano como es la experiencia consciente. Yo no lo tengo nada claro y ahí ando a vueltas con unos y con otros, pero el caso es que si no conocemos bien la función de la consciencia, razón de más para ser prudentes a la hora de afirmar que los LLMs son conscientes.

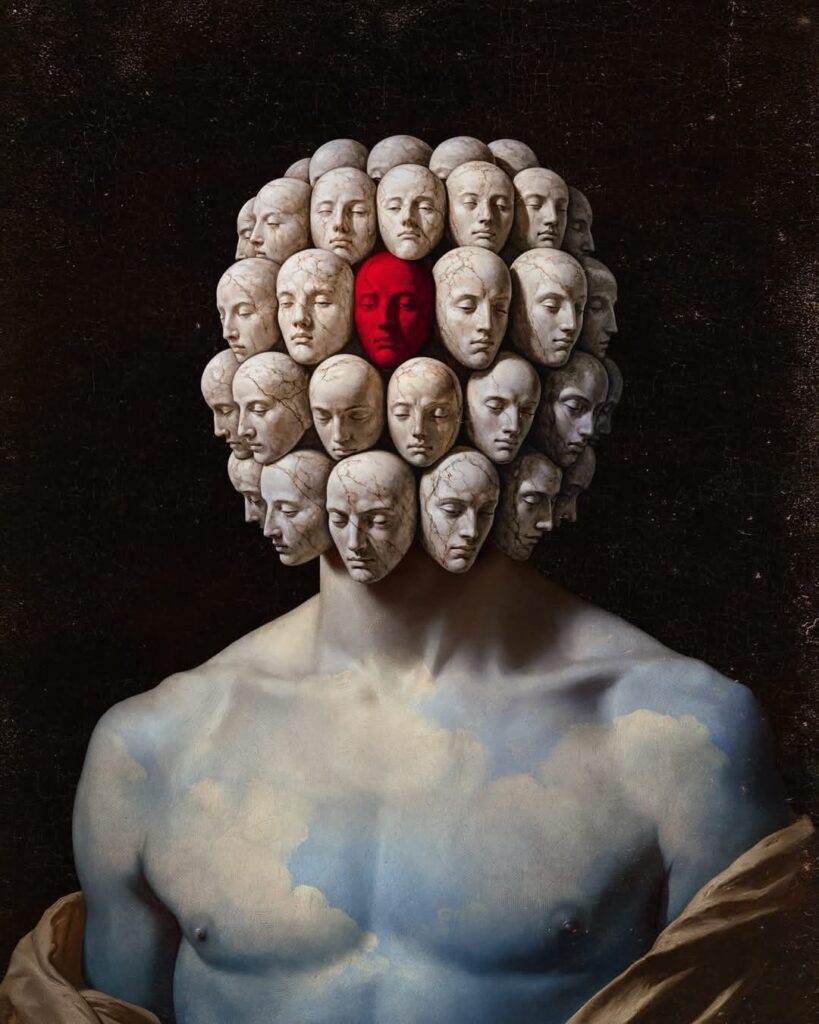

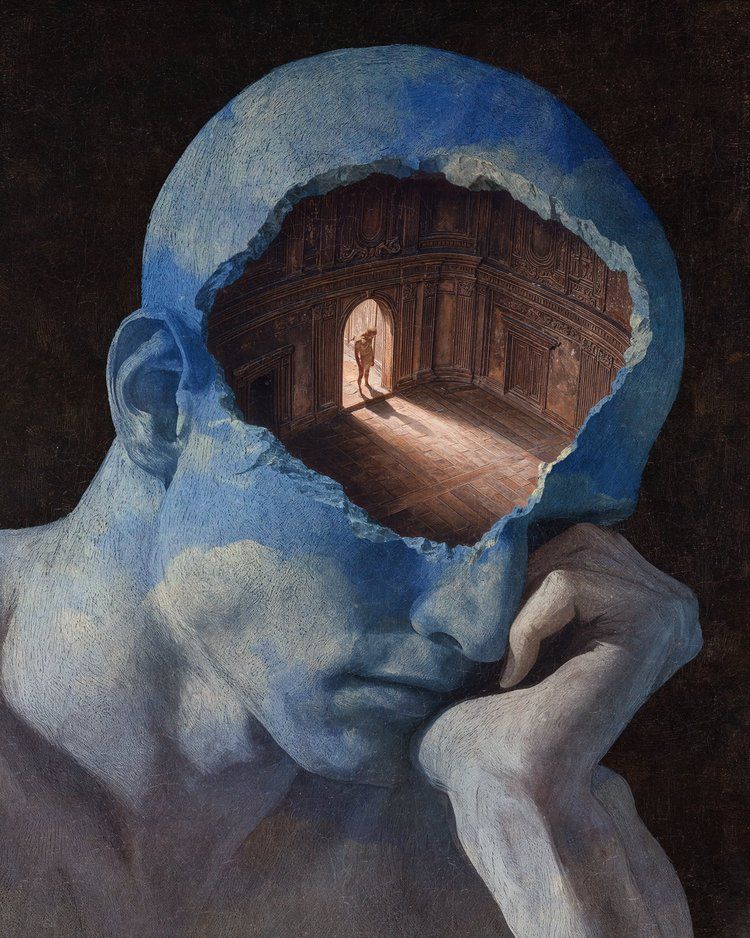

b) Sí que sabemos algunas cosas de la consciencia y no se ajustan, para nada, a las cualidades de los LLMs. Siempre recurro a la lista que hace Gerald Edelman y Giulio Tononi en el magnífico El Universo de la consciencia. Allí nos dan una buena serie de características de la consciencia. Por ejemplo, su privacidad (nadie más tiene acceso a mi experiencia), su carácter unitario e integrado (mi experiencia consciente se me presenta como un todo coherente de todas mis modalidades sensoriales), variada en intensidad (puedo estar muy atento a algo o apenas darme cuenta), dirigida (mediante la atención), quizá equiparable a la memoria a corto plazo, con un funcionamiento serial y limitado (no se nos da bien la multitarea consciente) y parecida a un flujo contínuo (la famosa definición de William James). La consciencia parece un «espacio» subjetivo, un «lugar» en el que sentimos, deseamos, sufrimos, anhelamos, amamos, odiamos, percibimos el paso del tiempo, saboreamos un sabroso filete, olemos el aroma de un embriagador perfume, tenemos orgásmos, nos duelen las muelas, sentimos miedo al leer un libro de Stephen King, envidiamos el nuevo coche del vecino… La consciencia es ese extraño lugar donde transcurre nuestra vida y sin el cual nada tendría ni el más mínimo sentido. Es por eso que decimos que el único órgano que no querríamos que nos trasplantaran es el cerebro, porque ahí, de alguna extraña manera, se entreteje nuestra experiencia consciente. Entonces, cuando hablamos de esta riqueza del mundo consciente y luego analizamos el funcionamiento de un LLM… ¿Alguien encuentra algún encaje? ¿Tiene algo que ver el mecanismo de transformers que pondera la importancia de cada token dentro de un contexto lingüístico con todo lo que acabamos de decir? ¿En serio que alguien puede creer verdaderamente que un LLM tiene ese espacio subjetivo en el que sufre, ríe, sueña… solo porque coloca tokens de forma adecuada? ¡Eso es un non sequitur de libro!

5. Tu perspectiva es terriblemente antropocéntrica. Es posible que la máquina no tenga una experiencia consciente similar a la humana ¿Cómo te atreves a poner la consciencia humana como vara de medir toda consciencia?

Pues sí amigo, mi perspectiva es antropocéntrica porque lamentablemente no tengo ni la más remota idea de cómo será otro tipo de consciencia (Recordad el murciélago de Nagel). Y lo que hacen en la actualidad los ingenieros que intentan crear consciencia en máquinas es intentar imitar las cualidades de la consciencia humana en dichas máquinas ¿Qué podemos hacer si no? Ojalá conociéramos qué se siente al ser una estrella de mar (si es que se siente algo) pero a día de hoy no nos queda otra que trabajar con lo que sabemos.

Además, argumentar de esa manera es cometer mi querida falacia del falso escocés: cambiar la definición en el curso de la discusión para que se reencaje. Me explico. Te propongo argumentos en contra de la idea de que un LLM sea consciente, y cuando no los puedes rebatir redefines tu posición: pues consciencia a lo mejor no es eso, a lo mejor las máquinas tiene otra cosa diferente. Y por supuesto, no dices absolutamente nada de esa cosa diferente que «sienten» las máquinas. Y otra vez más la carga de la prueba: si dices que las máquinas tienen otra forma de sentir el mundo tienes que traerme argumentos y evidencias a favor de eso, no pedirme a mí que te demuestre que eso no es posible.

6. A fin de cuentas, tanto las máquinas como nosotros solo somos un conjunto de átomos, ¿por qué entonces no vamos a poder construir consciencia sintética?

Tienes toda la razón, nadie dice que no vayamos a poder construir nunca consciencia sintética ¡Yo mismo trabajo en intentar conseguirlo! Pero eso no dice nada en contra de la afirmación de que los LLMs no son conscientes. Sí, la consciencia ha de responder a una combinación concreta de átomos, pero te aseguro que los LLMs no constituyen la configuración de átomos adecuada.

7. Los nazis exterminaron judíos negándoles su humanidad, al igual que ahora los israelitas hacen lo mismo con los palestinos. Cuando deshumanizamos a otros seres humanos, justificamos su maltrato ¿No estarás justificando eso mismo con las máquinas? ¿Y si verdaderamente fueran conscientes y capaces de sufrir? ¿No habría ya que otorgarles derechos y defensa legal? Desde tu postura estaríamos negándoles estos derechos ¡Estas justificando un apartheid del silicio!

En términos generales, en mi vida defiendo que no hay que tener actitudes destructivas con nada ni con nadie: obviamente con personas y animales (en mi casa me cuesta hasta matar a una mosca), pero también con máquinas y objetos. A mis hijos les digo que hay que tratar bien todas las cosas, y me enfado mucho cuando rompen algo por romperlo. Dicho esto, yo haría una llamada de precaución cuando nos estuviéramos acercando bastante más a la consciencia. Si, verdaderamente, comenzáramos a construir dispositivos en los que comienza a entreverse con rigor y seriedad la posibilidad de que puedan sufrir, habría que supervisar experimentos y legislar. Siempre he defendido la idea que allí donde exista la posibilidad de sufrimiento, allí hay un sujeto de derechos. Sin embargo, tranquilos, a día de hoy estamos tan lejos de construir consciencia en máquinas que no tienes que preocuparte por borrar un programa o porque tu smartphone pase «hambre». Tengo instalado en mi ordenador LM Studio, un software para ejecutar LLMs en local. He descargado y ejecutado algunas versiones de Llama, Mistral o Gemma, y después de juguetear un rato las he borrado ¿Habrán sufrido por ser eliminadas? ¿Lo que he hecho puede ser equivalente a matar gatitos? No, por Dios. Seamos serios.

Dos ideas clave:

1. Se confunde constantemente el concepto de información con el de consciencia. Si yo hago un pequeño robot para que llegue a una meta esquivando obstáculos en un circuito, podría programarlo con un «contador de dolor» que sume 1 cada vez que el robot colisiona con un objeto. Entonces, programo una red neuronal artificial para que minimice la función del contador del dolor. Pongo el robot en el circuito (mejor en una simulación para ahorrar muchísimo tiempo) y entreno a la red. Todo funciona muy bien y consigo que el robot esquive obstáculos y llegue a la meta sin problemas. Incluso si observamos sus movimientos, vemos que son muy gráciles, casi como los de un ser vivo en el mundo real. Entonces nos preguntamos: ¿siente dolor mi robot cada vez que se choca con un obstáculo? ¿Siente deseo de llegar a la meta? NO, claro que NO. El robot tiene información de su entorno, pero no consciencia. Incluso si hacemos que el robot sea mucho más inteligente añadiéndole funciones: un mapa tridimensional, ajustes de control de aceleración, algoritmos de optimización de trayectorias… NO, nada de eso va a dar un ápice de consciencia al robot. Estamos confundiendo tener información de algo con ser conscientes de algo, por lo que sumar más y más información podrá hacer la máquina más inteligente, pero no más consciente.

Mi smartphone tiene cierto «auto-conocimiento» de sí mismo: «sabe» de su nivel de batería. El indicador de la pantalla se llega a poner rojo cuando la batería está muy baja ¿Tiene mi smartphone auotoconsciencia? ¿Comienza a sentir mi smartphone hambre cuando tiene la batería al 20%? No, de hecho es que mi smartphone no tiene un sí-mismo, no tiene un «sujeto» que «sepa» lo que le ocurre, no tiene ninguna identidad que delimite qué es su «Yo» y qué no lo es. Esto lo hablamos más detenidamente en esta entrada.

2. Se confunde el hecho de que la simulación computacional sea una maravillosa herramienta para estudiar la mente con la tesis de que la mente es una simulación computacional. De nuevo voy a repetir una muy manida metáfora para explicar esta idea: En tu ordenador creas una excelente simulación de una vaca con un altísimo nivel de detalle. En la granja virtual que has creado para ella, la vaca se comporta de manera absolutamente indistinguible de una vaca real. Es más, tu programa es tan bueno que te podría servir de herramienta para predecir el comportamiento de vacas reales. Sin embargo, la vaca de tu simulación no podrá darte leche que tú puedas saborear. Por mucho que la ordeñes virtualmente, su leche no te quitará el hambre. Solo podrá darte leche simulada. Pues igual nos pasa con la consciencia. Las herramientas matemáticas que simulan comportamientos conscientes podrán ser muy útiles guías de la investigación, pero no son conscientes. Se está confundiendo el mapa con el territorio.