Como ahora está tan de moda hablar de riesgos existenciales para la humanidad, vamos a jugar a hacer algunos cálculos. Cuando nos dicen que hay, por ejemplo, un 10% de que la humanidad se extinga en los próximos años mediante un colapso climático, se nos pone la piel de gallina. Tenemos un 90% de salir vivos pero un 10% ya asusta ¡Hay que tomar medidas sin dudarlo! Y pueden ponerse las cosas mucho peores. Cuando leemos estos espeluznantes percentiles los solemos entender de forma aislada: en un artículo sobre el clima veo solo el porcentaje del fin del mundo por catástrofe climática, mientras que si leo otro sobre la Tercera Guerra Mundial únicamente veré la probabilidad de holocausto nuclear, y si leo otro sobre virus artificiales veré aisladamente la probabilidad de pandemia letal. Pero es que hay que caer en la cuenta de que los distintos escenarios del fin del mundo no son excluyentes, es decir, que no se dé uno no quiere decir que no se vaya a dar otro, por lo que si queremos hacer un pronóstico más acertado del futuro hay que calcular la probabilidad combinada de todos los posibles fines del mundo. Pongamos unos cuantos y estimemos, un poco arbitrariamente eso sí, unos percentiles:

Colapso climático: 10%

Holocausto nuclear: 10%

Pandemia global: 10%

Calculemos. La probabilidad de que no se diera nunca ninguno de los tres fines del mundo es igual a (9/10)*(9/10)*(9/10) = 729/1000. Ahora restamos esa probabilidad de 1 (del 100%), y obtenemos 271/1000, es decir, un 27,1%. Este porcentaje va asustando más. Y nos podemos seguir asustando si proponemos más posibles causas del fin del mundo y le asignamos sendas probabilidades. El controvertido filósofo de Oxford, Nick Bostrom, en su artículo Existential Risks: Analyzing Human Extinction Scenarios and Related Hazards de 2002, propone aproximadamente unos veinte riesgos existenciales: mal uso deliberado de nanotecnología, holocausto nuclear, la simulación informática en la que vivimos se cae por alguna causa, una superinteligencia mal programada, un agente biológico diseñado mediante ingeniería genética, un error accidental de nanotecnología, desastres físicos, una enfermedad natural, impacto de cometa o asteroide, calentamiento global descontrolado, agotamiento de recursos naturales o destrucción ecológica, un mal gobierno o cualquier desequilibrio social que detenga el desarrollo tecnológico, presiones genéticas, parón tecnológico, una super mente subida a la red toma el control, una superinteligencia defectuosa (que parece que no es lo mismo que mal programada), un régimen totalitario global, la degeneración de nuestros valores fundamentales en una carrera por la colonización del cosmos (muy rara ¿no?), exterminio por una civilización extraterrestre y, por supuesto, algo imprevisto.

Siendo equitativos, y para que nadie se ofenda, ponderamos todos estos riesgos por igual, con un 10% de posibilidades. Hacemos el cálculo otra vez. La probabilidad de que nada ocurra es de (9/10) elevado a 20, es decir, de 0.12157665459. Lo restamos de nuevo a 1 y nos da un 87,84% de posibilidades de holocausto final. Si Bostrom ha enumerado bien todos los riesgos existenciales posibles y si cada uno de ellos tiene, al menos, un 10% de posibilidades de ocurrir, rezad todo lo que sabéis, porque el doomsday va a llegar.

Pero tranquilos, que todo esto no son más que sandeces variadas. En primer lugar me gustaría saber cómo calculan los percentiles de partida ¿Cómo calculan que hay un 10% de probabilidades de colapso climático? ¿Por qué no 23,46% o 99,12%? ¿Cómo alguien puede saber de alguna manera las probabilidades de un holocausto nuclear? Respuesta: se los inventan, se los sacan de la chistera arbitrariamente, basándose, a lo sumo, en intuiciones y corazonadas. Me hace gracia cuando se hace una encuesta a nosecuantos expertos de un campo de investigación, preguntándoles cuánto queda para que llegue tal o cual avance, como la cura del cáncer o la teletransportación a escala humana. Con los datos recogidos se hace un promedio y se saca un titular: «Según la medicina el cáncer tendrá cura para 2035». Estudio absurdo porque el promedio no indica absolutamente nada, ya que cada entrevistado se ha inventado el dato. Si el médico en cuestión acaba de leer un artículo en donde se ve un progreso en el campo, estará más optimista y apostará por una fecha más cercana, mientras que si ha discutido con su pareja o no ha desayunado pondrá una fecha más lejana. Nadie puede hablar con propiedad de fechas porque si se pudiera, ya estarían muy cerca del descubrimiento. Precisamente, no saber cómo curar el cáncer es no saber también cuándo llegará su cura.

Y en segundo lugar: una trampa estadística consistiría en ir añadiendo más posibles fines del mundo: cuantos más pongamos, más porcentaje a favor del doomsday. Bostrom pone unos veinte, pero podríamos echarle más imaginación (aunque reconozco que más que Bostrom es difícil) y poner más, subiendo cada vez un poquito más el percentil ¿Y si proponemos un apocalipsis zombi? O varios tipos de éste y así subimos aún más: zombis debido a un virus, zombis debido a la radioactividad de un ensayo nuclear que salió mal, zombis debido a un proyecto militar de crear un soldado perfecto… ¿Y la rebelión de los simios? ¿Nadie recuerda ya a Charlton Heston gritando descorazonado al ver la Estatua de la Libertad semienterrada en una playa? O, pensando en una película que a mí me gustó mucho: ¿Por qué no la llegada de una especie de demonios que si los ves te suicidas? ¿No recordáis a Sandra Bullock navegando por los rápidos con niño y niña? ¿No os acordáis de Birdbox (titulada en España como «A ciegas»)? O, lo pongo un poco más difícil: ¿Alguién ha leído El día de los Trífidos de John Wyndham (hay una miniserie pero creo que es muy mala)? Habla de una rebelión de las plantas (en ella se basó El Incidente de Shyamalan).

Con esto del fin del mundo, nuestra memoria colectiva está muy cargada de ciencia-ficción, y eso hace que distorsionemos mucho nuestro juicio. Pero una cosa es que el común de los mortales yerre en sus pronósticos y otra que los responsables de la comunidad académica, científica y tecnológica caigan en las mismas estupideces. La ciencia-ficción es maravillosa, pero desde luego, no puede ser una herramienta fiable para pronosticar el futuro. Y no me canso de repetir que la estadística es una herramienta fundamental para comprender el mundo (Y no puedo creer lo poco conocida que es en mi gremio), pero hay que saber que también puede usarse de manera muy tramposa. Bostrom hace un juego mezclando fantasía y trampas de probabilidad. No le hagáis mucho caso.

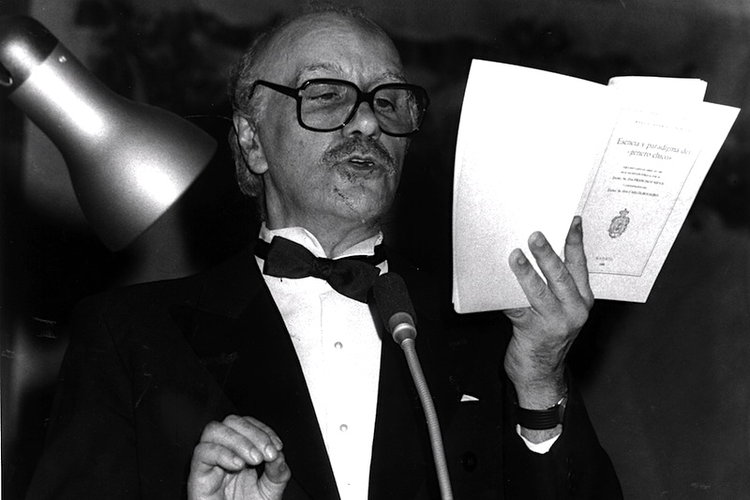

Post Data: en muy poquito saldrá un libro titulado Superar la «adolescencia tecnológica»: materiales para un debate en la que varios autores reflexionamos sobre el impacto de la tecnología en el mundo actual. Mi aportación es una reflexión mucho más amplia que la de este artículo, precisamente, sobre si tenemos que tomarnos en serio los riesgos existenciales pronosticados por estos nuevos profetas ¡Comprad el libro!

Oh, yeah!!!